Торренты на ссд это конечно сверхразум

Ну, крутить торренты круглосуточно на ссд это действительно надмозг ![]()

Хотя простое одиночное скачивание никак его не убивает, иногда можно, когда большие объемы и скорость.

Я читаю в основном фантастику. Технические книги повергают меня в уныние, я их открываю только тогда, когда нужно что-то новое узнать, с чем раньше не сталкивался, а для работы мне вполне хватает собственного опыта.

Во-первых, на всех новых девайсах стандартный комплект это ssd/nvme. Предлагаете от торрентов вообще отказаться в таком случае? ![]()

Во-вторых, ssd это не девочка-девочка на свадьбу, чтобы его беречь. Ну отлетит он не через 7 лет, а через 5…Железо целиком раньше придется менять все-равно.

Тоже читаю много всякого, но только “ушами” ![]() Глаза текстом убивать неохота, да и неудобно в дороге например пялиться в книгу или ридер. Наушник в ухе решает

Глаза текстом убивать неохота, да и неудобно в дороге например пялиться в книгу или ридер. Наушник в ухе решает ![]()

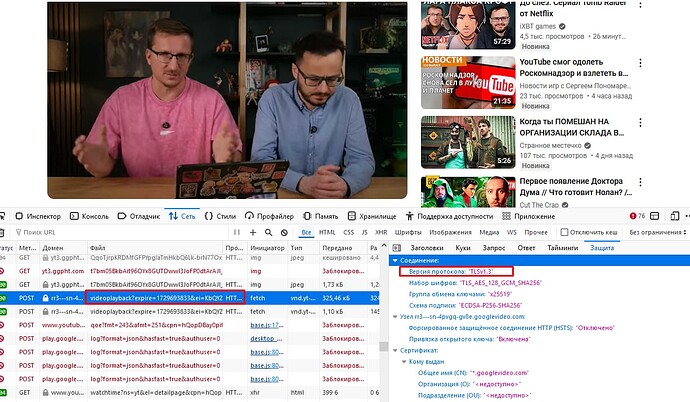

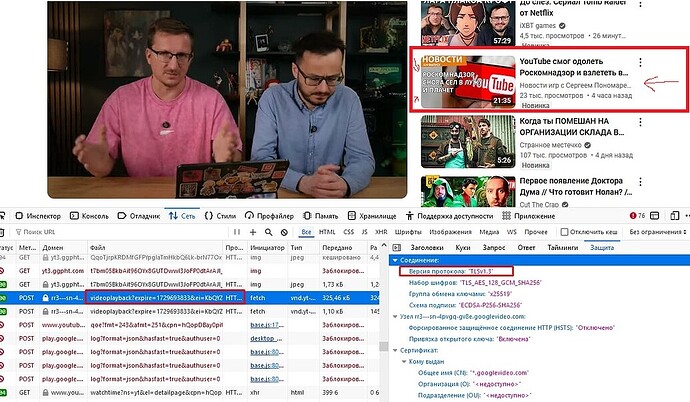

Может кто объяснить по поводу TLS1.3? На ютубе вижу в соединении что используется TLS1.3, но видео все равно не работает. Хотя вроде как все сайты где используется TLS1.3 должны без всяких настроек обходить блокировки РКН? Так же сайт amnezia.org тоже блокируется РКН, хотя там TLS1.3.

Гуглвидео использует quic и http1.1 c tls 1.2, насколько мне известно.

Это верно. Еще ни разу не видел к ним запрос типа HTTP/2 (h2), что как я понимаю соотв. TLS 1.3

На http2 так же можно вешать tls1.2, согласно RFC7540

Но хухел такое не использует, и, видимо, после внедрения quic никто апгрейдом легаси не занимался, поэтому мы видим старый http1.1

А вот в самом сайте достаточно ресурсов через http2

НЕ верно.

@KDS, @manwithbox

Товарищи, попробуйте в браузере сделать минимальную версию tls 1.3 и запустите ютуб ![]()

Мне лениво. И вообще пофиг )

Сергей, перелогинься! ![]()

Окей кэп ![]()

Ну тогда просто поверь наслово ![]()

Кстати при принудительном tls 1.3 все работает даже немного быстрее в целом, все сайты. Но часть не работают вообще, те которые на tls 1.2, но среди важных таких практически уже нет.

Я к тому веду, что НЕ только паттерны используются для одиночных пакетов. Есть разбор потока данных и их тспу пытается анализировать, и только потом паттерны применять. если бы просто каждый пакет сравнивался с паттерном, то или всё уже бы заблокировалось или не хватило бы (или как раз не хватает) паттаренов чтобы каждый заблоченный ClientHello “ЗАпатернить” во все его вариантах. Т.е. разбитым по первому байту , 2му и N-ному. Поэтому там какие-то хитрые алгоритмы пытаются использовать. Что вот после установки соединения должен быть ClientHello в нем нам надо выцепить SNI, его сравнить и заблочить. Но отсюда и работают схемы дурения. И примеры уже были кгда 20 фейков посылали и только потом реальный ClintHello. И он проходил, потому что видимо там стояло условие что ну уж 20 то пакетов явно достаточно проверить ну и т.д.

Вообще как ты уже говорили мы не знаем как точно работает ТСПУ можно только предполагать.

Так в том то и дело что очень много пакетов. Как их анализировать так чтобы выцепить правильные. И сколько паттернов можно залить в коробку? Сколько вариантов есть разбить ClintHello? и послать части (N частей) в разном порядке, пермешивая их с похожими пакетами, а может дублируя и т.д.

Но я не говорю что кто-то из ркн сидит и запрет или гудбай на стенде запускает. Я к тому что анализируется поток с учетом последовательности пакетов, а не просто if Packet==Pattern.

Кстати, тут он прав. 1.3 действительно ходит c http1.1, но реального прироста производительности никакого нет.

Тогда в чем отличие в Протокол HTTP/1.1 и HTTP/2 я не пойму. В чем-то другом кроме шифрования?

Там по спецификациям. 1.1 очень старый, с конца 80х, там данные передаются в открытом виде. Во 2 версии уже бинарные кадры. И еще куча всяких улучшений, можно почитать в инетах.

Одно из отличий, что HTTP/2 заголовки в двоичном виде передаются. Получается более эффективно и с точки зрения трафика и с точки зрения анализа их (даже банальное распознать где заканчивается заголовок и начинается тело запроса/ответа)

Вопрос насколько это реально на эффективность влияет.

Ну и лучше конвейерная обработка запросов и мультиплексирование. Опять же как это оценить.

Там рассказ об аналитике, сравнивали октябрь этого года и прошлого, аудитория, даже с учетом замедлений/блокировок просела в среднем на полпроцента ![]()

Дак и я о том ![]()

Снова обычный мужик блоху подковал…

хмм, у меня без всяких отключений в FF у всех серверов ggc - TLS 1.3 просто по умолчанию